- Statistische Prozesskontrolle

- SQC vs. SPC

- Was ist Versuchsplanung (DOE)?

- Varianzanalyse (ANOVA)

Statistische Methoden in der Qualitätsverbesserung

Der Einsatz statistischer Methoden zur Qualitätsverbesserung kann viele Formen annehmen, darunter:

Hypothesentests

Es werden zwei Hypothesen ausgewertet: eine Nullhypothese (H0) und eine Alternativhypothese (H1). Die Nullhypothese ist ein „Strohmann“-Argument, das in einem statistischen Test verwendet wird. Die Schlussfolgerung besteht darin, die Nullhypothese entweder abzulehnen oder nicht abzulehnen.

Regressionsanalyse

Bestimmt einen mathematischen Ausdruck, der die funktionale Beziehung zwischen einer Antwort und einer oder mehreren unabhängigen Variablen beschreibt.

Statistische Prozesskontrolle (SPC)

Überwacht, steuert und verbessert Prozesse mithilfe statistischer Verfahren. SPC erkennt, wenn Prozesse aufgrund von Abweichungen aus besonderen Gründen (Abweichungen, die durch besondere Umstände verursacht werden und nicht dem Prozess innewohnen) außer Kontrolle geraten. Anwender können dann nach Möglichkeiten suchen, diese Abweichungen aus dem Prozess zu entfernen.

Versuchsplanung und -analyse

Planen, Durchführen, Analysieren und Interpretieren kontrollierter Tests zur Bewertung der Faktoren, die eine Antwortvariable beeinflussen können.

Die Praxis, anhand einer kleinen, repräsentativen Stichprobe Rückschlüsse auf eine größere Population zu ziehen, entstand im frühen 20. Jahrhundert. William S. Gosset, besser bekannt unter seinem Pseudonym „Student“, musste kleine Proben aus einem Brauprozess entnehmen, um bestimmte Qualitätsmerkmale zu verstehen. Der von ihm entwickelte statistische Ansatz (heute Einstichproben-t-Test genannt) wurde später von R. A. Fisher und anderen weiterentwickelt.

Jerzy Neyman und E. S. Pearson entwickelten in den 1920er Jahren einen umfassenderen mathematischen Rahmen für Hypothesentests. Dieser umfasste Konzepte, die Statistikern heute vertraut sind, wie zum Beispiel:

- Fehler 1. Art – fälschliches Ablehnen der Nullhypothese.

- Fehler Typ II – fälschlicherweise wird die Nullhypothese nicht abgelehnt.

- Statistische Aussagekraft – die Wahrscheinlichkeit, die Nullhypothese korrekt abzulehnen.

Fishers Varianzanalyse (ANOVA) ist die statistische Grundlage für viele statistische Analysen, beispielsweise in Studien zur Wiederholbarkeit und Reproduzierbarkeit von Messgeräten und anderen geplanten Experimenten. Die ANOVA hat sich als sehr hilfreiches Instrument erwiesen, um zu untersuchen, wie Variationen auf bestimmte Faktoren zurückzuführen sind.

W. Edwards Deming und andere haben den wahllosen Einsatz statistischer Inferenzverfahren kritisiert und darauf hingewiesen, dass falsche Schlussfolgerungen gezogen werden könnten, wenn man nicht aus einem stabilen System stichprobenartig stamme. Bei der Betrachtung von Daten sollte die Art der durchgeführten statistischen Studie im Mittelpunkt stehen.

Laden Sie unser E-Book herunter

Laden Sie unser kostenloses E-Book herunter und erfahren Sie, wie GQ Interim Ihr Unternehmen mit professionellen Führungslösungen transformieren kann!

Statistische Prozesskontrolle

Mithilfe von Verfahren zur statistischen Prozesskontrolle (SPC) können Sie das Prozessverhalten überwachen.

Das wohl erfolgreichste SPC-Tool ist die Regelkarte, die ursprünglich Anfang der 1920er Jahre von Walter Shewhart entwickelt wurde. Eine Regelkarte hilft Ihnen bei der Datenaufzeichnung und zeigt Ihnen, wann ein ungewöhnliches Ereignis eintritt, z. B. eine sehr hohe oder niedrige Beobachtung im Vergleich zur „typischen“ Prozessleistung.

Kontrollkarten versuchen, zwischen zwei Arten von Prozessvariationen zu unterscheiden:

- Gemeinsame Ursache für Variationen, die dem Prozess innewohnen und immer vorhanden sein werden.

- Variationen aufgrund besonderer Ursachen, die auf externe Quellen zurückzuführen sind und darauf hinweisen, dass der Prozess außerhalb der statistischen Kontrolle liegt.

Mithilfe verschiedener Tests lässt sich feststellen, wann ein außer Kontrolle geratenes Ereignis vorliegt. Je mehr Tests durchgeführt werden, desto größer ist jedoch auch die Wahrscheinlichkeit eines Fehlalarms.

Hintergrund

Während des Zweiten Weltkriegs kam es in den USA zu einem deutlichen Anstieg der Verwendung von Kontrollkarten, um die Qualität von Munition und anderen strategisch wichtigen Produkten sicherzustellen. Nach dem Krieg nahm die Verwendung von SPC etwas ab, wurde jedoch später in Japan mit großem Erfolg wieder aufgenommen und wird bis heute fortgesetzt.

Viele SPC-Techniken wurden in den letzten Jahren von amerikanischen Unternehmen wiederentdeckt, insbesondere als Bestandteil von Qualitätsverbesserungsinitiativen wie Six Sigma. Die weite Verbreitung von Kontrolldiagrammverfahren wurde durch statistische Softwarepakete und immer ausgefeiltere Datenerfassungssysteme erheblich unterstützt.

Im Laufe der Zeit wurden weitere Tools zur Prozessüberwachung entwickelt, darunter:

- Kumulative Summendiagramme (CUSUM): Die Ordinate jedes dargestellten Punkts stellt die algebraische Summe der vorherigen Ordinate und der jüngsten Abweichungen vom Ziel dar.

- Diagramme mit exponentiell gewichtetem gleitendem Durchschnitt (EWMA): Jeder Diagrammpunkt stellt den gewichteten Durchschnitt der aktuellen und aller vorherigen Untergruppenwerte dar, wobei der jüngsten Prozesshistorie mehr Gewicht verliehen und älteren Daten weniger Gewicht beigemessen wird.

In jüngerer Zeit haben andere die Integration von SPC mit Engineering Process Control (EPC)-Tools befürwortet, die Prozesseingaben regelmäßig ändern, um die Leistung zu verbessern.

Statistische Qualitätskontrolle versus statistische Prozesskontrolle (SQC vs. SPC)

1974 stellte Dr. Kaoru Ishikawa in seinem Buch „Guide to Quality Control“ eine Sammlung von Werkzeugen zur Prozessverbesserung zusammen. Weltweit bekannt als die sieben Werkzeuge der Qualitätskontrolle (7–QC) sind sie:

- Ursache-Wirkungs-Analyse

- Kontrollblätter/Strichlisten

- Regelkarten

- Grafiken

- Histogramme

- Pareto-Analyse

- Streuanalyse

Zusätzlich zu den grundlegenden 7–QC-Tools gibt es auch einige zusätzliche Tools, die als die sieben ergänzenden (7– SUPP) Tools bekannt sind:

- Datenstratifizierung

- Defektkarten

- Ereignisprotokolle

- Prozessablaufdiagramme/-karten

- Fortschrittszentren

- Randomization

- Bestimmung des Stichprobenumfangs

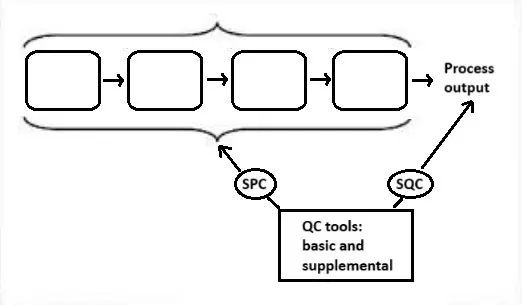

Statistische Qualitätskontrolle (SQC) ist die Anwendung der 14 statistischen und analytischen Werkzeuge (7–QC und 7–SUPP) zur Überwachung der Prozessausgaben (abhängige Variablen). Statistische Prozesskontrolle (SPC) ist die Anwendung derselben 14 Werkzeuge zur Kontrolle der Prozesseingaben (unabhängige Variablen).

Die folgende Abbildung stellt diese Beziehungen dar.

Was ist Versuchsplanung (DOE)?

Dieser Zweig der angewandten Statistik befasst sich mit der Planung, Durchführung, Analyse und Interpretation kontrollierter Tests zur Bewertung der Faktoren, die den Wert eines Parameters oder einer Gruppe von Parametern steuern.

Ein strategisch geplantes und durchgeführtes Experiment kann umfangreiche Informationen über die Auswirkung eines oder mehrerer Faktoren auf eine Antwortvariable liefern. Viele Experimente beinhalten die Konstanz bestimmter Faktoren und die Veränderung der Ausprägungen anderer Variablen. Dieser One-Factor-at-a-Time (OFAT)-Ansatz zur Wissensverarbeitung ist jedoch im Vergleich zur gleichzeitigen Veränderung der Faktorausprägungen ineffizient.

Viele der heutigen statistischen Ansätze zur Versuchsplanung gehen auf die Arbeiten von R. A. Fisher aus dem frühen 20. Jahrhundert zurück. Fisher zeigte, wie sich häufige Probleme bei der Analyse vermeiden lassen, wenn man sich vor der Durchführung eines Experiments Zeit nimmt, dessen Planung und Durchführung sorgfältig zu überdenken. Zu den Schlüsselkonzepten bei der Erstellung eines Versuchsplans gehören Blockierung, Randomisierung und Replikation.

Ein gut durchgeführtes Experiment kann Antworten auf Fragen liefern wie:

- Was sind die Schlüsselfaktoren in einem Prozess?

- Bei welchen Einstellungen würde der Prozess eine akzeptable Leistung liefern?

- Was sind die Schlüssel-, Haupt- und Wechselwirkungseffekte im Prozess?

- Welche Einstellungen würden zu weniger Variationen in der Ausgabe führen?

Es wird ein repetitiver Ansatz zum Wissenserwerb empfohlen, der typischerweise die folgenden aufeinanderfolgenden Schritte umfasst:

- Ein Screening-Design, das den Bereich der zu bewertenden Variablen einschränkt.

- Ein „vollfaktorielles“ Design, das die Reaktion jeder Kombination von Faktoren und Faktorstufen untersucht und versucht, sich auf einen Wertebereich zu konzentrieren, in dem der Prozess nahe an der Optimierung ist.

- Ein Antwortoberflächendesign zur Modellierung der Antwort.

Blockierung

Wenn die Randomisierung eines Faktors nicht möglich oder zu kostspielig ist, können Sie durch Blockieren die Randomisierung einschränken, indem Sie alle Versuche mit einer Einstellung des Faktors und dann alle Versuche mit der anderen Einstellung durchführen.

Randomization

Bezieht sich auf die Reihenfolge, in der die Versuche eines Experiments durchgeführt werden. Eine randomisierte Reihenfolge hilft, die Auswirkungen unbekannter oder unkontrollierter Variablen zu eliminieren.

Replikation

Wiederholung einer kompletten Versuchsdurchführung inklusive Aufbau.

Varianzanalyse (ANOVA)

ANOVA ist ein grundlegendes statistisches Verfahren zur Bestimmung des Einflusses eines Faktors oder einer Gruppe von Faktoren auf die Gesamtvariation. Dabei wird die Gesamtvariation eines Datensatzes in aussagekräftige Komponenten unterteilt, die bestimmten Variationsquellen zugeordnet sind, um eine Hypothese zu den Parametern des Modells zu testen oder Varianzkomponenten zu schätzen. Es gibt drei Modelle: fix, zufällig und gemischt.

Fazit

Zusammenfassend lässt sich sagen, dass statistische Methoden die Grundlage für eine effektive Qualitätsverbesserung bilden. Tools wie Hypothesentests, Regressionsanalysen, SPC und Versuchsplanung ermöglichen es Unternehmen, Erkenntnisse zu gewinnen, die Leistung zu überwachen und Abweichungen zu kontrollieren. Durch die Unterscheidung zwischen allgemeinen und besonderen Ursachen, die Optimierung von Prozessinputs und das systematische Testen von Änderungen ermöglichen diese Techniken Entscheidungsträgern, Ergebnisse zu verbessern, Abfall zu reduzieren und die Gesamteffizienz zu steigern. Der Einsatz dieser Methoden fördert eine Kultur der kontinuierlichen Verbesserung, die auf Daten und wissenschaftlichem Denken basiert.

Sind Sie an Interim Expert interessiert?

Entdecken Sie, wie Interim Management die Effizienz Ihres Unternehmens drastisch steigern kann. Setzen Sie sich mit unserem Team in Verbindung, um zu erfahren, wie die Zusammenarbeit mit GQ Interim Ihr Unternehmen verbessern wird.

- Starten Sie innerhalb weniger Tage

- Datenbank mit 10 000+ Beratern

- Lösung entscheidender Probleme in Ihrem Unternehmen

- Maßgeschneiderte Lösungen für Ihre Geschäftsanforderungen

- Nachgewiesene Ergebnisse mit messbarem Einfluss

Ähnliche Artikel

- Ein Beispiel für eine Balanced Scorecard zeigt, wie Unternehmen mehr als nur die finanzielle Leistung messen können. Die von Robert Kaplan und David Norton entwickelte Balanced Scorecard verfolgt Ziele in den Bereichen Finanzen, Kunden, interne Prozesse sowie Lernen und Wachstum. Durch die Abstimmung dieser Perspektiven stellt sie sicher, dass die täglichen Abläufe die langfristige Strategie und das nachhaltige Wachstum unterstützen.

- Die Theory of Constraints (TOC) ist ein strukturierter Ansatz zur Verbesserung der Unternehmensleistung, der sich auf den einzigen begrenzenden Faktor konzentriert - die Einschränkung. Ganz gleich, ob es sich um einen Engpass in der Produktion, die Marktnachfrage oder eine Umsatzlücke handelt, die TOC beantwortet drei Kernfragen - was soll geändert werden, worauf soll geändert werden, und wie soll die Änderung herbeigeführt werden - und treibt die kontinuierliche Verbesserung durch fünf disziplinierte Schritte voran: identifizieren, ausnutzen, unterordnen, erhöhen und wiederholen.

- Software Quality Assurance stellt sicher, dass die Software die Anforderungen der Stakeholder durchgängig erfüllt, indem sie Fehler vermeidet und prüft, ob die Produkte den definierten Qualitätsattributen (z.B. Zuverlässigkeit, Sicherheit, Leistung) entsprechen. Die Kombination von Fehlermanagementpraktiken mit standardbasierten Qualitätsmodellen wie ISO/IEC 25010 hilft Teams bei der Planung, Messung und kontinuierlichen Verbesserung der Qualität während des gesamten Lebenszyklus.

- Bei unserer Arbeit treffen wir sehr oft auf viele Symbole und Abkürzungen, z.B. FMEA, PPAP, CC, SC usw. Als ich mein erstes internes Audit bei meiner Arbeit durchführte, musste ich auch die Umsetzung der CE-Kennzeichnung überprüfen. Zuvor habe ich recherchiert, was diese CE-Kennzeichnung ist, um in diesem Bereich nicht völlig verloren zu sein. Was ist sie also und wie wird sie verwendet?